반응형

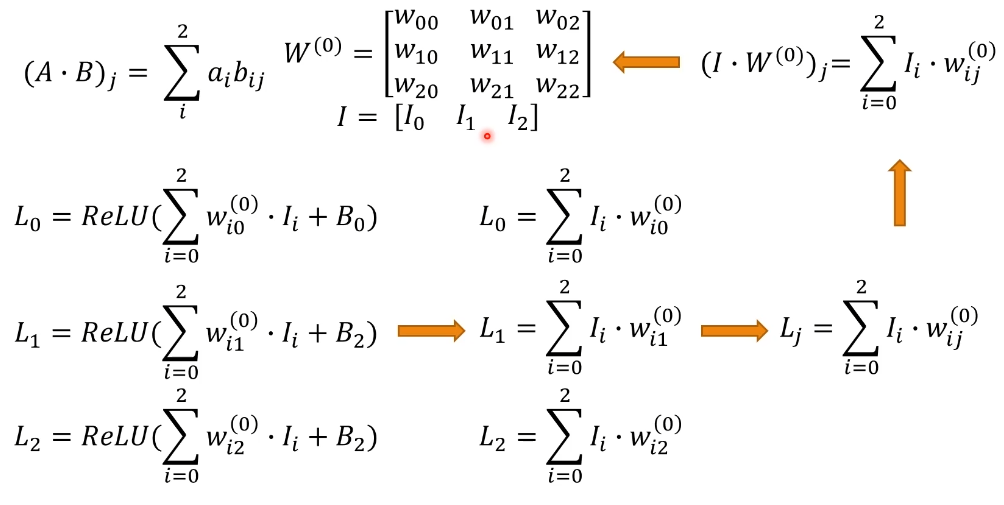

벡터화 - Vectorization

- 행렬화와 비슷하다.

- 위 그림과 같은 이유로 아래와 같이 표현할 수 있다.

- 벡터를 통해 Input과 Unit이 각각 3가지 라는 것을 알 수 있다.

복잡했던 기존의 식

벡터화를 통해 정리할 수 있다.

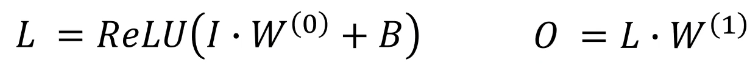

정리하자면 아래와같이 나타낼 수 있다.

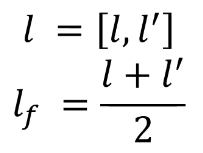

- 인풋이 아래와 같이 행렬형태의 벡터라면, Loss도 아래와 같이 두개가 나온다.

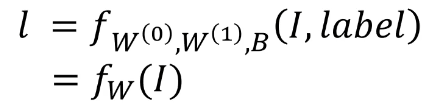

Derivatives

f(a) 를 줄이려면 a를 줄여야 하기 때문에, W를 값을 찾을 때 미분값을 찾아서 차를 구하여 계산한 것.

Gradient Desent

아래와 같이 표현이 가능하다.

반응형

'머신러닝' 카테고리의 다른 글

| Autograd, NN 모델 (0) | 2021.06.18 |

|---|---|

| PyTorch (0) | 2021.06.18 |

| Feed - Foward 정리 (0) | 2021.06.18 |

| Back - Propagation 3 (0) | 2021.06.18 |

| Back - Propagation 2 (0) | 2021.06.18 |

댓글