Variants of LSTM

Peephole Connections

- 망각, 입력, 출력게이트에 이전 Cell State의 정보가 전달되는 방식이다.

- ft, it 는 Ct-1 (이전 CellState의 정보) 이 입력됨

- ot는 Ct (현재의 CellState 정보)가 입력된다.

- 차원이 하나씩 증가하기 때문에, LSTM의 계산량이 늘고, 성능이 개선됨

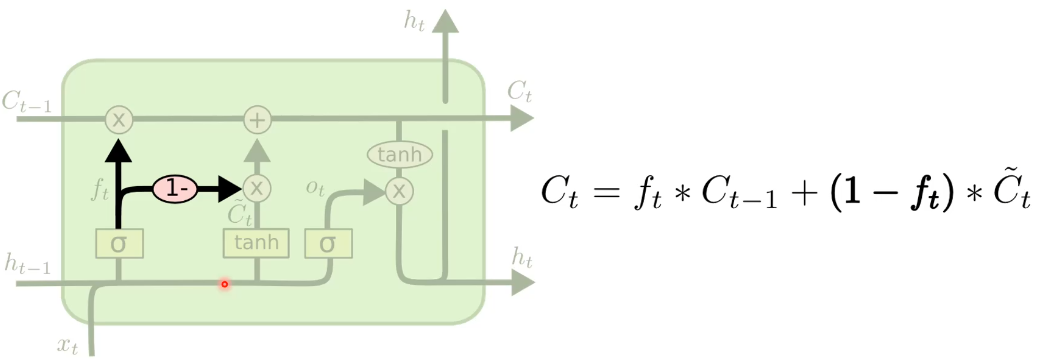

Coupled Forget and Input Gates

- LSTM에서는 망각 - 입력 - 출력게이트에서 시그모이드 함수를 사용했지만, 이것은 망각게이트와 입력게이트를 합쳐놓은 것이다.

- 망각게이트는 시그모이드의 값을 입력, 입력게이트는 1-ft (반전)를 통해 입력하게 된다.

Gated Recurrent Unit

- LSTM보다 계산량을 줄이면서, 일부 데이터에서 성능이 비슷함.

- 자연어 처리, Speech Recognize.

- 장기기억과 단기기억이 나뉘어 입력되었던 LSTM과 달리, 통합해서 입력하게 됨.

- CellState가 없으며, Output Gate가 없다.

- 따라서 파라미터의 개수가 적다.

TIMIT Acoustic-Phonetic Continuous Speech Corpus

Performance Comparison

- 이 그래프는 TIMIT DATASET을 여러 모델들이 Traning 시킨 정확도와 파라미터 수를 나타내는 그래프이다.

- NOG, NFG, NOG는 각각 인풋, 망각, 아웃풋 게이트를 없앤 모델이다.

- CIFG는 앞서 있었던 커플~ 모델이다.

- NOG, NFG, NOG는 눈에띄게 성능이 나빠졌고, CIFG는 파라미터 수가 매우 적지만 FGR, NP와 비슷한 정확도를 보여준다.

Bidrectional LSTM

- 기본적으로 두개의 LSTM을 이용하는 것이다.

- 기존의 LSTM은 뒤에 있는 정보는 앞에 영향을 끼칠 수 없다.

- 따라서 이 LSTM은 뒤에 있는 정보가 앞의 출력물에 영향을 끼칠 수 있다.

- 데이터 입력시 실제론 모두 동시에 입력하기 때문에 계산이 가능하다.

- 이 방법은 RNN도 사용할 수 있다.

Seq2Seq Model

One-Hot

- 우리의 언어를 벡터로 표현하는것.

- 안녕 : [1,0,0,0...,0]

자연어 처리(NLP)

- 사람들이 말하는 것을 어떻게 인식할지, 번역할지.

- 사람들의 말과 언어를 컴퓨터 언어로 어떻게 표현할 지.

- 텍스트나 음성을 이해하고 반응하는 기계.

- 모든 단어를 Vector화 (One-Hot)

- 입력이 유동적이어야 함.

- RNN, LSTM 모델이 적합 : Sequence가 얼마나 될 지 주어지지 않기 때문.

NN 모델

- 위와같은 모델은 입력의 수가 고정되어 있어야 가중치를 계산할 수 있다.

- 자연어 처리같이 입력이 유동적인 곳은 사용하기 어렵다.

RNN 모델

- 입력의 수가 달라져도 계산이 양이 늘어날 뿐, 계산이 가능하다.

- 자연어가 늘어날 때마다 RNN의 구조의 양만 늘어날 뿐이다.

- RNN구조는 다음 입력값에 영향을 주기 때문에, 말의 상호관계도 파악 할 수 있게된다.

자연어 번역 프로세싱

- 입력된 언어를 One Hot 형태로 변경한다.

- 이 개수에 따라 인코더가 모델의 단계의 개수를 정해준다.

- 인코더는 장기기억을 저장하는 Cell State 역할을 수행한다.

- 중간의 Output은 모두 무시한다.

- 자연어 처리의 개수만큼 Output을 가지고 있다. (S)

- 새로운 입력으로 null을 주고 빠져나온 output을 순차적으로 입력하여 마침표가 나올때 까지 반복한다.

- 첫번째 Output은 Er이 나오게 Labeling, 두번재 Output은 liebte가 나오게 Labeling 한다.

- 이 Labeling을 더하기 / 평균 등으로 Back-프로퍼게이션 한다.

- LSTM의 L.F 을 줄이기 위해 모든값은 Loss값을 줄여야한다.

- 짧은 문장에는 효과적인 방법이다.

Pytorch의 LSTM

'머신러닝' 카테고리의 다른 글

| 인공신경망의 학습 (0) | 2021.06.17 |

|---|---|

| 인공신경망의 기초 (0) | 2021.06.17 |

| Long Short - Term Memory (0) | 2021.06.02 |

| Maximum A Posteriori Estimation (0) | 2021.05.27 |

| Bayesian Estimation (0) | 2021.05.26 |

댓글