반응형

Weight의 초기값을 설정해 주는 것이다.

각 가중치들의 편차와 초기값들, 활성함수에 따라서 Update 값이 달라진다.

예를들어 위의 활성함수는 높은 초기값을 가진다면, 미분을 해도 값의 변화가 미미하게 된다.

시그모이드에서 값들의 표준편차가 1인경우

미분값들이 작기 때문에 값들의 학습이 되지 않은 것을 볼 수 있다.

시그모이드에서 값들의 표준편차가 0.01인 경우

미분값들이 매우 밀접하게 붙어있기 때문에 모든 레이어의 값이 동일하고, NN의 표현력을 제한하게 된다.

시그모이드에서 Xavier 초깃값

표준편차가 0.01인 경우

전부 0으로 수렴하고 있음.

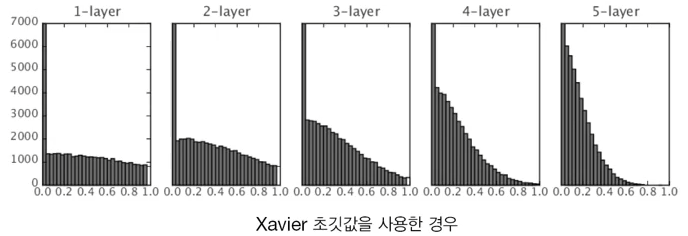

Xavier 초깃값을 사용한 경우

레이어마다 분포도가 다르기 때문에, 각 레이어 마다 특징들이 달라질 수 있음.

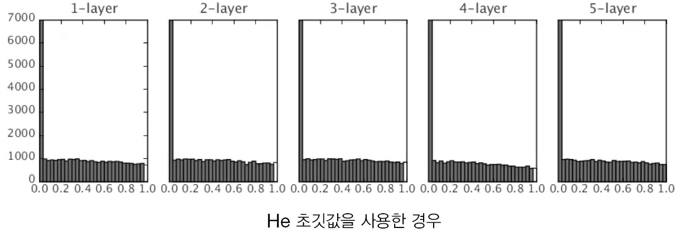

He 초깃값을 사용한 경우

전부 균일하게 분포되어 있음.

- 모든 레이어를 활용을 잘 하고 있음.

위의 세 경우 공통적인 사항으로, 0인 경우가 매우 많음.

- NN의 전부를 활용하는 것이 아닌 일부 만을 활용하고 있다.

반응형

'머신러닝' 카테고리의 다른 글

| Maximum likelihood Estimation 1 (0) | 2021.05.15 |

|---|---|

| 머신러닝이란? (0) | 2021.05.14 |

| Batch Normalization 2 & Well - Known Models & Recurrent Neural Network (0) | 2021.04.28 |

| Batch Normalization & Overfitting & HyperParameter (0) | 2021.04.23 |

| Optimizer 2 (0) | 2021.04.21 |

댓글